Germane Cognitive Load

因為大腦學得最好…係未得到所有答案嗰陣時

大腦學語言最有效,係要自己串連線索,唔係只係收翻譯。設計啲對話唔會即刻話哂畀你知意思,等學習者要揣摩、推想同自己諗通。Germane Cognitive Load 呢個概念話比我哋知,呢種努力先會幫你大腦建立永久「知識結構」,就好似細路仔靠重複聆聽、理解就浸入咗語言一樣。研究證明「啱啱好嘅難度」同「有啲迷糊但識估」先至最啱長遠學到語言 — 因為語言學唔係教出嚟,係要由你腦自己砌出嚟。

真正學語言,唔係靠死記

Cognitive Load Theory

喺神經科學角度,大腦要「真係學到嘢」,就要落啲腦汁去搵出自己版本意思—呢個就叫 “Germane Cognitive Load”。呢個概念嚟自 Cognitive Load Theory(Sweller, 1988),將大腦負荷分成三種:

- Intrinsic Load – 內容本身難度,例如日文發音比英文難

- Extraneous Load – 額外負擔,例如亂咁教或太多資訊喺畫面

- Germane Load – 「好」嘅負擔,因為令大腦要砌理解,例如搵新字同見過情境串連

當俾大腦自己試下諗、分析、聯想,大腦會建立 schema,即「認知模型」— 呢個就係真正嘅學習過程。

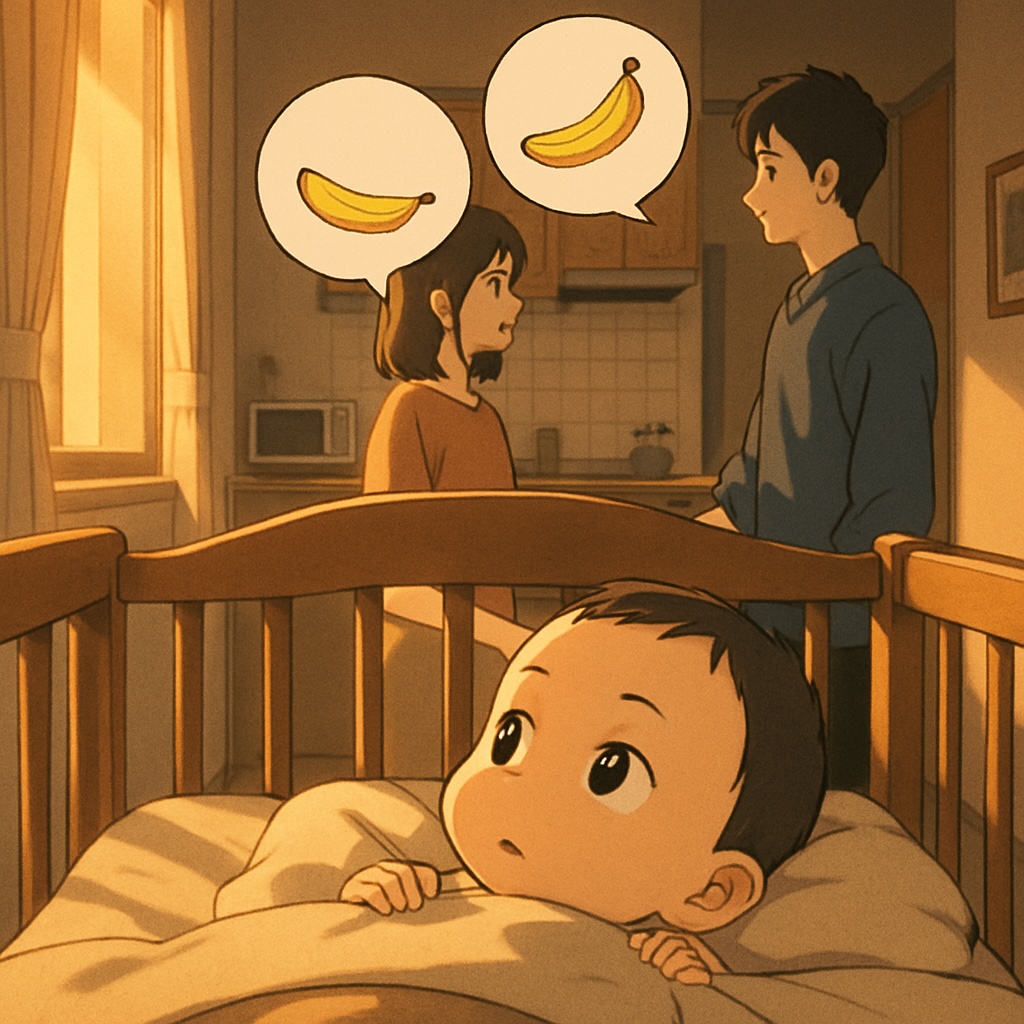

細路仔天生就係咁學語言

Patricia Kuhl(華盛頓大學)發現,六至十二個月大嘅細路仔用 statistical learning ——即係靠重複聽聲音自己捉pattern。例如聽到「banana」好多次,大腦會識分呢個係一隻字,唔係三個音節。細路係靠情境學,唔係背解釋。媽媽同時講「食飯啦」&手上拿住匙羹,細路會連結「食飯」呢個聲音等於見到飯同溫暖感覺。佢哋唔係第一次就明哂,但大腦會慢慢砌拼圖,經過重複,最自然咁建立 germane load。

「Desirable Difficulty」——啱啱好嘅難度先令腦成長

Robert Bjork(UCLA)叫呢個原則做 Desirable Difficulty —— 大腦最佳嘅學習狀態係啲嘢唔易又唔過難:

- 太易→大腦唔使諗

- 太難→大腦嘥氣放棄

- 啱啱好→大腦先至會努力砌新理解

所以學語言唔好「答曬畀你」,要製造啱啱好嘅難度,大腦先至會自動揣摩解讀——可以最有效地刺激神經元連接(synaptic strengthening)同neuroplasticity。

Germane Cognitive Load 背後嘅科學

試想像以下語言App對話:

👧 “昨日、映画を見たよ。”

きのう、えいがをみたよ。

kinō, eiga o mita yo.

🧒 “へえ、誰と?”

へえ、だれと?

hē, dare to?

👧 “友だちと。とても楽しかった!”

ともだちと。とてもたのしかった!

tomodachi to. totemo tanoshikatta!

呢個例子,App可能未必即時解釋哂每隻字,例如昨日(きのう / kinō — 昨日)又或者楽しかった(たのしかった / tanoshikatta — 好開心)。學習者要靠講「電影」、「朋友」等情境自己估緊講緊開心嘅經驗。

大腦會:

• 串連情境→估意思

• 捉動詞pattern→留意到“〜た”代表過去式

• 曬多幾次又見番呢pattern,大腦就會明得多啲

呢種就係細路學語言嘅方式,不過而家我哋用科技,令大人學快好多又學得好啲。

Nick Ellis(密歇根大學)發現,啱啱好嘅迷糊(manageable ambiguity),可以刺激大腦用 Bayesian inference來估同修正意思。少少唔明=大腦開始思考!學習者要「由情境估」唔係等人話比你知答案,大腦好似科學家咁自己計邊個解釋最掂咁。所以會變咗主動學習——大腦主導砌意思,而唔係等人畀答案。

宜家時代 AI 秒秒都可以答你哂一切,但如果用AI話哂畀你知,大腦反而唔使郁,germane load 就唔見咗。MIT研究話,用LLM(好似ChatGPT)反而低過自己諗同寫嘅大腦活躍度(EEG activity)。所以學語言嘅AI,要做你嘅「思考拍檔」(Cognitive Coach),唔好做「自動字典」。例如AI可以反問:「你覺得呢個字喺呢度代表咩呀?」又或focus指出仲唔明嘅位,咁先幫你keep住germane load,大腦真正有得發揮。

人類學語言最叻,因為大腦:

- 收到真實情境資訊

- 要自己揣摩理解

- 得到貼身feedback

- 經歷唔同場景不停重複

細路重複過千次先出口術,大人一樣得,只係今時今日有科技幫手「推你思考」,而唔係「次次白紙黑字答畀你」。真正學語言唔係儲生字,而係訓練你大腦「更加醒估、串連、揣摩」——就好似我哋一出世講第一句語言時果個方式咁自然。

References:

- Sweller, J. (1988). Cognitive load during problem solving: Effects on learning. Cognitive Science.

- Bjork, R. A. (1994). Memory and metamemory considerations in the training of human beings.

- Kuhl, P. K. (2004). Early language acquisition: Cracking the speech code. Nature Reviews Neuroscience.

- Ellis, N. C. (2002). Frequency effects in language processing: A review with implications for theories of implicit and explicit language learning. Studies in Second Language Acquisition.

- MIT Media Lab (2025). Your Brain on ChatGPT: Accumulation of Cognitive Debt (preprint).